L’intelligence artificielle (IA) est en train de transformer de nombreux domaines créatifs, et la musique ne fait pas exception. Des premiers logiciels de musique assistée par ordinateur (MAO) aux modèles génératifs d’aujourd’hui, l’IA ouvre de nouvelles perspectives aux musiciens, amateurs et professionnels. Parmi les plateformes les plus intrigantes de cette révolution, Riffusion se distingue en permettant de générer de la musique en temps réel à partir de simples textes.

Dans cet article, nous allons explorer Riffusion, comprendre son fonctionnement, le comparer à d’autres plateformes d’IA musicale, retracer l’histoire de la création musicale assistée par ordinateur et esquisser une prospective sur l’avenir de la musique et de l’IA.

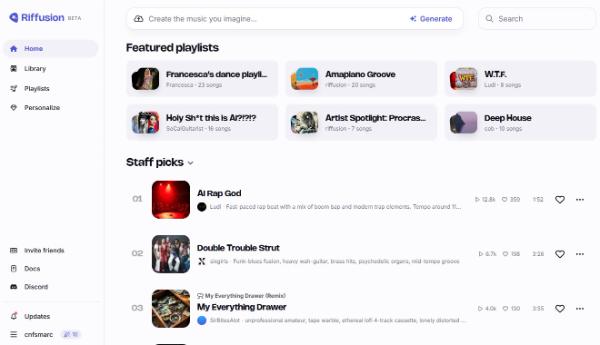

Riffusion est un modèle d’IA basé sur Stable Diffusion, une architecture à l’origine conçue pour générer des images, mais adaptée ici à la création musicale. Son principe est simple : l’utilisateur entre un texte décrivant une ambiance, un style musical ou un instrument, et l’IA génère un extrait sonore en temps réel.